Plus volumineuses, plus variées, plus rapidement produites, les « Grosses Données » sont le fruit de la numérisation croissante de notre société. Les technologies sont déjà mures pour en tirer parti tout en simplifiant leur usage. Ainsi, le nouveau paradigme du Big Data est au cœur des nouveaux enjeux de la recherche technologique Française pour les Systèmes du futur de plus en plus complexes.

Un Buzz word qui rappelle celui du Cloud

« Big Data » a été élu mot numérique de l’année 2012, succédant ainsi à « Cloud Computing » élu en 2011 (élection du mot numérique 2012 de David Fayon http://davidfayon.fr/2013/01/big-data-mot-numerique-2012/); personne ne s’en étonnera. S’agit-il du nouveau « Buzz word » du monde de l’informatique qui en est friand ou bien un phénomène bien réel annonçant de grandes transformations ?

Comme pour le Cloud, il n’existe pas de traduction de « Big Data » en Français qui soit adoptée. Est-ce un critère de pertinence des Buzz words ? Le terme parfois utilisé de « Déluge de données » ne semble pas faire sa place.

A l’été 2011, un grand fournisseur informatique inondait les aéroports du monde entier avec sa publicité « When Cloud meets Big Data ». Rappelons-nous les publicités en 2010 sur les radios généralistes vantant le Cloud à des auditeurs qui ne pouvaient raisonnablement pas comprendre de quoi il s’agissait.

Au contraire du Cloud à ses débuts, depuis l’émergence visible du terme « Big Data » en 2011, peu de remises en cause de ce phénomène annoncé sont apparues. Aujourd’hui, d’aucuns critiquent cette expression qu’ils considèrent, pour partie à juste titre, comme une formule marketing destinée à vendre des solutions, alors que l’enjeu est aujourd’hui celui de l’usage des données maintenant disponibles en masse (à l’instar d’Harper Reed, Responsable technologique de la campagne 2012 de Barack Obama, cité par ZDNET.fr).

Tous les informaticiens parlent aujourd’hui couramment le Petaoctets (1 Po ≈ 1000 Teraoctets). Avec le Big Data, préparons-nous à apprendre à parler l’Exaoctet (1 Eo ≈ 1000 Petaoctets), le Zettaoctets (1 Zo ≈ 1000 Exaoctets) ou encore le Yottaoctets (1 Yo ≈ 1000 Zettaoctets).

Selon IBM, chaque heure sont générés 2,5 trillions d’octets de données, soit 2,5 Po. Ils prévoient que pendant l’année 2020 seront générés 35 Zettaoctets, alors que seulement 1 Zettaoctets de données informatiques ont été générés par l’humanité entre le début de l’informatique (les années 1940) et l’année 2010.

Disons-le ici clairement, nous sommes convaincus de nous situer au-delà du Buzz word, et de vivre avec le Big Data une révolution majeure de notre économie au sens large, appuyée par des évolutions techniques, elles-mêmes alimentées par les progrès constants de la micro-électronique et la loi de Moore.

Big Data = Smart Data

Avec le Big Data, les données, substrat pour l’analyse et la prise de décision, vivent une quadruple rupture, communément appelée celle des 3V (telle qu’énoncée en 2011 par le cabinet McKinsey & Cie), conjuguée avec celle des couts, qui en caractérisent les différences avec le domaine connu du « business analytics » qui a fait la croissance du secteur informatique dans les années 90 :

- V pour Volume : avec le Big Data, l’échelle est multipliée par des facteurs de plusieurs milliers. Les entreprises ne sont plus obligées de sélectionner les données pour leurs analyses, elles peuvent les intégrer toutes, provenant de diverses sources, abatant des silos établis depuis plusieurs années.

- V pour Vitesse : bienvenue dans le temps réel et la production continue de données. Chaque seconde sont émis plus de 500 tweets, ce qui fait 50 millions chaque jour, ou encore 1 milliard en une semaine. Le Big Data, c’est l’analytique à la vitesse du transactionnel.

- V pour Variété : le Big Data englobe les données de tout type : images, texte, sources variées dont les réseaux sociaux, en général non structurées au contraire des bases de données relationnelles. Ainsi de la voix et des images qui deviennent des données comme les autres qu’on peut analyser, traiter, manipuler.

- Enfin, le Big Data se caractérise par la décroissance très significative du coût de stockage et des infrastructures informatiques en général, lui-même alimenté par la loi de Moore toujours active. Les architectures de données de type Hadoop permettent de diviser le coût de stockage et de traitement des données (TCO – Total Cost of Ownership) par 5, par rapport aux architectures classiques de bases de données relationnelles et de baies de stockage centralisées.

Lors des Entretiens Telecom Paristech sur le Big Data en décembre 2012, Pierre Barnabé (SFR) a défini le Big Data comme le moyen de « rendre intelligents et intelligibles des flux de données exponentiels ». Autrement dit, Big Data = Smart Data.

Le projet Google Flu (Suivi de la grippe) est un bel exemple d’application du Big Data aux moteurs de recherche. Les chercheurs de Google ont identifié une combinaison de 45 termes utilisés dans les recherches effectuées dans leur moteur de recherche, semblant être de bons indicateurs de la propagation de la grippe, qui se corrèlent très bien (via une modélisation mathématique), pour donner des prédictions fiables sur la couverture géographique de la grippe saisonnière extrêmement semblables avec les statistiques officielles issues des consultations médicales sur le terrain (http://www.google.org/flutrends/intl/fr/about/how.html). On imagine facilement ici l’intérêt d’un tel outil, rendu disponible gratuitement par Google.

« On s’amuse bien ici, on peut voir les données de tout le monde ! »

Big Data, fils de la Loi de Moore et d’Internet

Il paraît aujourd’hui impensable de parler de Big Data sans mentionner les quatre grands facteurs qui convergent dans le secteur fortement innovant des technologies de l’information et communément appelés SMAC, pour Social, Mobile, big dAta (ou analytics) et Cloud.

Certains prédisent que ces facteurs se combineront avec les nouvelles technologies cognitives et du langage (on parle aussi de « machine learning ») pour avoir un impact majeur sur l’économie du 21ème siècle.

Dit autrement, le phénomène du Big Data est directement alimenté par quatre forces génératrices :

– le Web 2.0 & les réseaux sociaux, avec le nouveau paradigme du Web 2.0 et de la génération par les utilisateurs des données sur le Web, incarné par les réseaux sociaux (1,1 milliards d’utilisateurs actifs Facebook en mai 2013) ;

– le Mobile: avec son smartphone, chaque être humain (1 milliard de smartphones en circulation en 2013 dans le monde) génère une quantité croissante de données: localisation, mails, photos, vidéos, tweets, etc.;

– l’Internet annoncé des objets & senseurs: on estime à plus de 10 milliards le nombre d’objets actuellement connectés par Internet sans fil dans le monde, nombre qui sera porté à plus de 30 milliards en 2020 (selon le cabinet ABI Research);

– enfin, le mouvement Open Data: les administrations publiques et para-publiques sont amenées à mettre à disposition librement et à tous les acteurs l’ensemble des données qu’elles génèrent et traitent.

Issu directement des nouveaux acteurs de la révolution Internet, le Big Data se caractérise aussi par de nouvelles technologies que ces entreprises ont développées et très souvent diffusées dans un modèle d’Open Source : citons Google avec le GFS (Google File System) à la source de HDFS (Hadoop Data File System), l’un des deux composants de Hadoop avec MapReduce (également créé par Google); Facebook avec Cassandra (Système de Gestion de Bases de données « No SQL ») libéré lui-aussi dans l’espace Open Source et largement utilisé (par exemple par Twitter) ; Amazon Elastic MapReduce (Amazon EMR), un service Web payant et non plus une technologie, permettant de traiter de grandes quantités de données de manière simple et économique dans le Cloud d’Amazon.

Big Data rime souvent avec Hadoop. En effet, ce projet Open Source de la fondation Apache a pour vocation la mise à disposition de bibliothèques de programmes permettant le traitement de volumes importants de données au moyen de clusters de serveurs standardisés et à bas coût (via HDFS) en utilisant un modèle simple de programmation, MapReduce, pour l’extraction des données. Les architectures Hadoop sont actuellement déjà largement utilisées dans des applications industrielles de nombreux secteurs d’activités.

Citons également les nouvelles applications orientées moteur de recherche (par exemple Dassault Systèmes Exalead) associées aux nouvelles technologies de transcription de la parole en texte et de la reconnaissance d’objet (Content-Based Image Retrieval) permettant de structurer automatiquement les contenus et d’y avoir accès.

Enfin, les modalités de représentation et de visualisation des Big Data et des informations qu’elles portent donnent lieu au développement de nouvelles technologies, les DataViz (DataVisualisations), au centre de la relation avec l’utilisateur et des usages du Big Data.

La simplexité du Big Data : un nouvel enjeu majeur pour la Recherche Française

“La Simplexité est l’art tout autant que la science de trouver et activer des solutions simples, efficaces et élégantes à des enjeux décisifs complexes.” (Le Cercle Les Echos, 25 nov 2011, Grégory Le Roy)

Est-ce que le nouveau paradigme du Big Data peut répondre en partie aux enjeux de l’ingénierie numérique de Systèmes de plus en plus complexes ?

Les Systèmes complexes, que sont par exemple les systèmes de transport multimodaux, rassemblant systèmes ferroviaires urbains, systèmes d’auto-partage, autobus, etc., demandent de nouvelles modélisations qui prennent en compte des données jusqu’à présent absentes du périmètre de jeu, par exemple les données produites en temps réel sur le déplacement des usagers. De telles données, associées aux données disponibles en mode « Open data », appellent les approches méthodologiques et technologiques du Big Data.

L’IRT SystemX (Institut de Recherche Technologique dédié à l’Ingénierie des systèmes du futur et soutenu par le Plan d’Investissement d’Avenir), porté par le Campus Paris Saclay et labellisé par le pôle de compétitivité « Systematic Paris-Region », comporte deux programmes de recherche appliquée : « Systèmes de systèmes » et « Technologies & outils d’ingénierie numérique », ainsi qu’un programme de formation et de relations PME.

Les projets de recherche du programme « Systèmes de Systèmes » rassemblent sur un même site, dans un mode « intégratif », des industriels (grands groupes, PME et ETI) de secteurs différents partageant des enjeux Systèmes proches, sur les trois thématiques que sont le Transport multimodal, la Sécurité, et la Gestion de l’Energie, en les associant avec les laboratoires académiques les plus pertinents, et des chercheurs en propre de l’IRT.

Les projets de recherche du programme « Technologies et Outils » se concentrent, eux, sur la maîtrise de systèmes et logiciels embarqués, de moyens de calcul à hautes performances, d’infrastructures de communication, de production et de distribution de l’énergie numérique (ou Cloud Computing), et la maîtrise de la modélisation, de la conception, de l’intégration et de la validation de grands systèmes, ainsi que sur le contrôle des outils d’ingénierie numérique pour le développement de maquettes numériques multi-échelles et multi-physiques.

Ainsi, l’IRT SystemX mène des projets de recherche rassemblant grands industriels, PME innovantes et laboratoires académiques, visant à résoudre les défis technologiques et scientifiques posés par l’ingénierie numérique de Systèmes complexes, au sein desquels le Big Data représente de plus en plus un enjeu scientifique tout comme une solution technologique. On pourra citer par exemple l’utilisation de techniques de DataViz pour une plateforme de simulation permettant d’analyser des résultats issus de niveaux de description différents et de nature hétérogène, ou encore la mise à disposition des architectures Hadoop « à la demande » par les opérateurs de Cloud Computing.

« Où en êtes-vous avec votre projet Big Data, M. Hoskins ? »

Citons également un projet de recherche appliquée que mène l’IRT SystemX sur les technologies visant à extraire des informations signifiantes à partir de flux très importants de données provenant de médias et de langues multiples, en mettant en œuvre certaines des technologies du Big Data associées à la science de la linguistique et au Web sémantique. Extraire ainsi des signaux faibles parmi des données fortement bruitées : l’une des applications du Big Data pour l’analyse d’opinion au travers des réseaux sociaux, par exemple.

Dans le même registre, la numérisation et le passage à la génération « intelligente » des réseaux électriques (les « smart grids »), associés aux architectures de type Internet & Social, sont de nature à nécessiter les approches Big Data de manière très directe. Les industriels qui participent aux projets de recherche de l’IRT SystemX au sein de sa thématique « Gestion intelligente de l’Energie » ont positionné le Big Data parmi les défis technologiques et scientifiques majeurs à résoudre.

L’excellence scientifique Française au service de l’industrie

L’excellence Française des laboratoires de recherche académique en mathématiques (algorithmes notamment), statistique, sémantique, linguistique, design (compétence clé pour le DataViz), et plus largement en sciences humaines, sont des atouts majeurs que l’IRT SystemX met au service des industriels – grands groupes, PME et ETI – qui participent à ses projets de recherche à contenu Big Data plus ou moins fort.

Autre signe de la réalité du nouveau paradigme du Big Data, le pôle de compétitivité Systematic Paris-Region, qui fédère en Ile de France plus de 700 acteurs industriels, PME et scientifiques, introduit pour la première fois le Big Data comme l’un des six axes technologiques prioritaires de son nouveau plan stratégique 2013-2018, parmi les plus porteurs de transformations et d’innovations.

Les thèmes principaux de recherche identifiés par le pôle Systematic sur cette thématique portent notamment sur l’Analyse et la fouille de données , la Modélisation par les données, et les Outils et méthodes de représentation et visualisation (DataViz).

Big Data, évolution technologique, révolution des usages…et révolution économique et sociétale?

Tout comme Le Cloud computing, le Big Data, évolution technologique, est une véritable révolution des usages qui implique une révolution managériale au sein des acteurs économiques, privés et publics. Après l’entreprise Cloud, voici venir l’entreprise Big Data, l’entreprise numérique, digitale, au sein de laquelle “la ressource première est bien l’information ou en tout cas la transformation du bruit en information pertinente” (Le Cercle Les Echos, 28/02/2013, Bruno Teboul).

L’ère du cognitif n’est plus très loin, et avec elle la promesse d’apporter la simplicité nécessaire pour le management de Systèmes de plus en plus complexes, et forcément de plus en plus numériques, au service de la société du 21ème siècle.

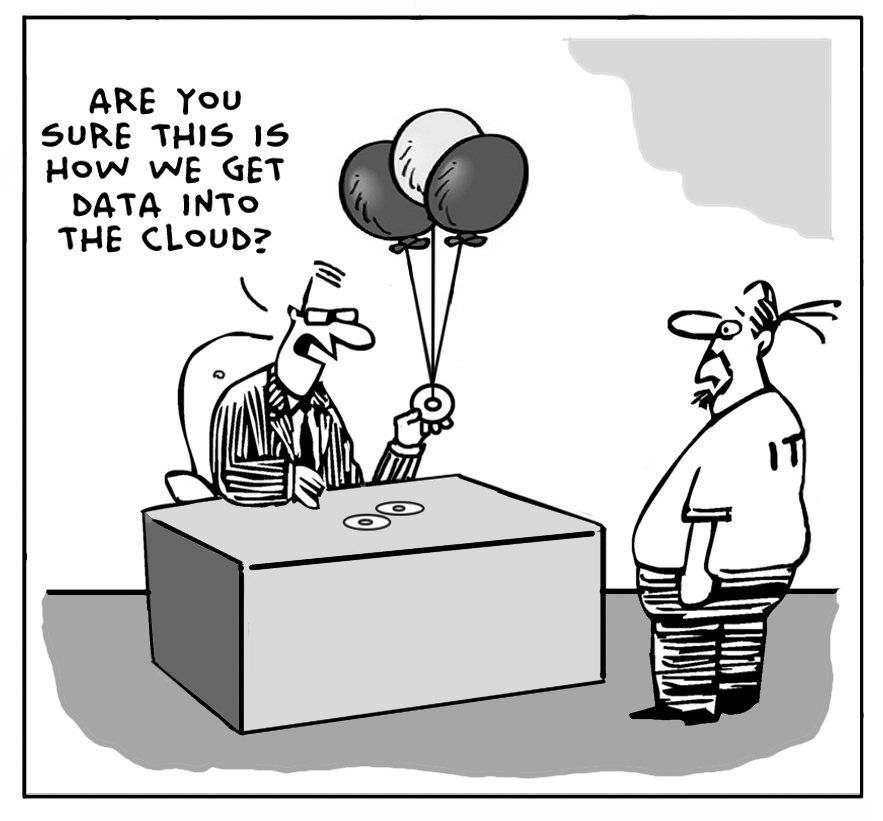

« Vous croyez vraiment que c’est ainsi qu’on met les données dans le Cloud ? »

Images copyright Cloudtweaks.com

Par François STEPHAN, Directeur du Programme “Systèmes de Systèmes” au sein de l‘Institut de Recherche Technologique SystemX, dédié à l‘ingénierie numérique des systèmes. Diplômé de l’Ecole polytechnique et de Telecom ParisTech, il a plus de 20 d’expérience professionnelle dans les technologies de l’information. Il est le co-auteur avec Jean-Pierre BRIFFAUT de l’ouvrage “Cloud computing : Évolution technologique, révolution des usages” publié en mai 2013 par les éditions Hermes Science – Lavoisier.